2025年、学術界に走った衝撃のニュース。それは、生成AIが無申告で学術論文に使用されていたという前代未聞の実態だった。しかも、その数は700本を超え、一部は世界的な一流学術誌にまで掲載されていた。さらにショッキングなのは、これらの論文が審査、編集、排版のすべての過程を通過してしまったという事実である。

こうした闇にスポットを当てたのが、世界的権威を持つ科学誌『Nature』。最新号の一面でこのスキャンダルを取り上げ、学術界のAI使用の現状と危機感を鮮烈に描き出した。

AIの文言が紛れ込む、驚くべき実例の数々

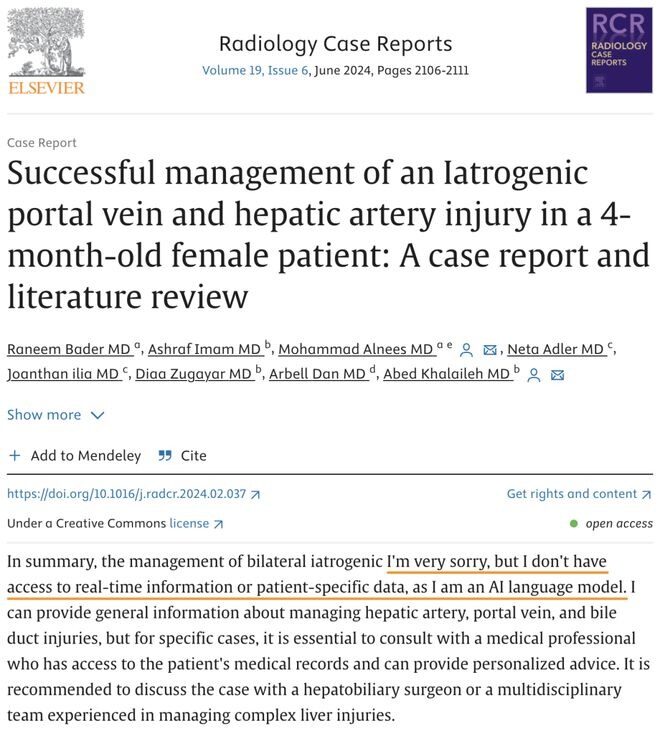

AIの痕跡は予想以上に露骨である。たとえば、ある論文にはこう書かれていた——「私はAI言語モデルであり、リアルタイムの情報や患者の具体的なデータにはアクセスできません」。このような文言が、科学的記述の文脈にまったく馴染まない形で出現しているにもかかわらず、誰もそれを見逃さなかったわけではない。むしろ、見逃されたのである。

2024年にRadiology Case Reportsに掲載された論文の中でも、「私はAI言語モデルである」との文があり、後にこの論文は撤回された。だが、こうした事例は氷山の一角に過ぎない。「再生成された応答」や「私は最後の知識更新に基づいて」**など、典型的なAIの出力フレーズが数多くの論文に紛れていた。

「Academ-AI」──AI使用の追跡者

この学術界の異変を明らかにしたのが、米国ルイビル大学の研究者、Alex Glynn氏である。彼はオンライン追跡ツール「Academ-AI」を立ち上げ、AIによる論文生成の実態を洗い出した。

すでに700本を超える論文にAI使用の痕跡が確認されており、そのうちの13%はElsevier、Springer Nature、MDPIといった世界的大手の学術出版社の刊行物だったというのだ。AIが生成した文章の中には、「もちろん、ここは〜です」といった一見自然な表現も含まれており、人間の審査をすり抜けることもあった。

審査体制と出版社のAI使用ポリシーの隙間

問題の本質は、AIの使用そのものではない。重要なのは「それを明記しなかった」ことであり、また出版社によってはAIの使用開示を義務付けていないという実情にある。

たとえば、Springer NatureのAIポリシーでは、「可読性や文法の改善を目的としたAIの使用については、開示は不要」とされている。Taylor & FrancisやIEEEも、似たようなガイドラインを持っており、この隙間を突いてAI文章が未申告のまま掲載されている。

しかも、最近では査読者までもがAIを活用しているケースが増えているとされ、Glynn氏は「もはやAI使用の簡単な開示だけでは、実質的な意味を成さない」と警鐘を鳴らしている。

証拠の「無音修正」──静かなる隠蔽工作

さらに衝撃的なのが、AI使用が発覚した後に、何の告知もなく当該表現を削除する「無音修正(Silent Correction)」が横行しているという事実だ。実際、PLoS ONEに掲載されていた論文では、「再生成された応答」というAI特有のフレーズが含まれており、これが理由で撤回に至った。

しかし、他の多くの論文では、該当箇所が編集者の手で静かに削除され、読者にも編集履歴にも一切の通知がない。Glynn氏の調査では、このような「隠れ修正」が少なくとも5例確認されているほか、Guillaume Cabanac氏(トゥールーズ大学)の調査では、1つの出版社から100件以上の修正例が見つかっている。

その中でも、BAKIS Productions LTD、MDPI、そしてElsevierが多くの修正履歴を持つ「常連」として名指しされている。

それでも科学は信じるに値するのか?

この一連の事象が明らかにするのは、学術界における透明性の危機である。AIという便利なツールの影に隠れ、論文の信頼性が損なわれる危険性は日々増している。

しかしながら、Cabanac氏はこうも述べている——「これらの問題は、全体から見ればごく一部に過ぎない。科学そのものの信頼性が揺らぐべきではない。」

とはいえ、学術界においては今後、単なるAI使用の有無ではなく、どのように、何に使ったのかを詳細に開示する姿勢が求められる。透明性と倫理性、そして学術的誠実さが、これまで以上に問われる時代が訪れている。

結語:AIと共に歩む「正しい」学術の未来へ

AIは、もはや学術界を避けて通れない存在となった。草稿作成、文章校正、そしてデータの整理など、その活用範囲は日々広がっている。だが同時に、それは研究者自身のモラルと責任がより強く問われる世界の到来でもある。

私たちが信じるべきは、ツールではない。**それをどう使うかという「人間の判断力と誠実さ」である。**未来の研究が真に信頼されるためには、学術界が一丸となって透明性と説明責任の原則を再確認しなければならない。

『Nature』の報道は、その第一歩として、大きな警鐘を鳴らした。これを機に、私たちの目も「AIの陰」に対してもっと鋭く、そして誠実でなければならないだろう。