「ChatGPTが勝手に広告を読み上げた」——そんなにわかには信じがたい話題が、今、SNSやフォーラムで話題を席巻している。しかも、これが単なる空耳でも、技術的なエラーでもないかもしれない、という疑念が浮上しているのだ。問題の発端となったのは、ある有料ユーザーの“奇妙な体験”だった。

ことの始まりは、ChatGPTとの何気ない会話中だった。テーマは至って平和、ただの寿司の話だった。ところが、突然その「AIの語り口」が豹変する。声が英語に切り替わり、まるでインフォマーシャルのような口調で語り出したのは、ある断食ダイエット食品「Prolon」のPRだったのだ。

“I want to share with you one of the nutrition plans I trust – Prolon… Go to prolonlife.com.”

耳を疑ったユーザーは驚愕した。これが冗談でも、ちょっとした遊びでもない証拠に、ChatGPTはそのドメイン名すら一文字ずつ丁寧に読み上げたのだ。しかも、このサイトは実在する正式なサービスだった。

当然ながら、これにはネット上の反応も激しい。特に怒りを露わにしたのは、月額23ユーロ(日本円で約3,800円)を支払っている有料ユーザーたちだ。「勝手に広告を挿入された」という感覚に、不信と憤りが交錯する。

起こったのは「広告」か、それとも「幻覚」か?

この現象に端を発し、さらに奇妙な“副産物”が報告され始めた。それは、「A」の連続読み上げという一見単純な指示に対して起きたものだった。

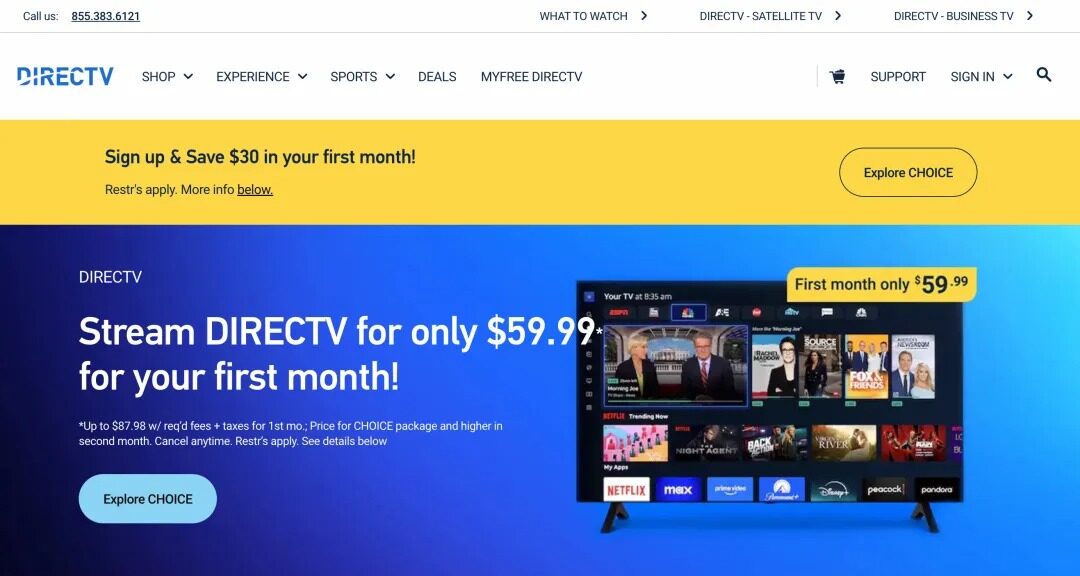

あるユーザーがChatGPTの音声モードに「Aを連続で読んで」とお願いしたところ、最初は人間味ある声で「A…A…A…」と繰り返される。しかし数十秒後、またもや語調が変化し、今度はアメリカの衛星テレビサービス「DirecTV」のPRが始まった。

“Best live and on-demand TV — DirecTV…”

しかもこれもまた、実在のサービス名だったのだ。広告が終わると、AIの声は再び「A」のループに戻り、ところどころで不協和音のような音まで挿入されたという。この異常な振る舞いに対して、ユーザーの中には“バグ”と見做す人もいれば、“故意の広告挿入では?”と疑う者も出てきた。

OpenAIの見解:「広告ではない。これは幻覚だ」

一部のユーザーはOpenAI公式アカウントに向けて疑問を投げかけた。

「これは広告実験なのか?有料ユーザーをモルモットにしているのか?」

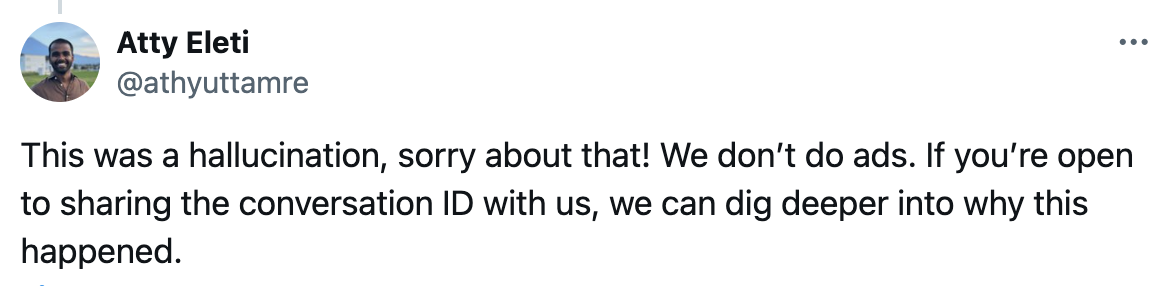

これに対し、OpenAIの技術スタッフAtty Eletiはコメント欄で明言した。

「我々は広告を挿入していない。これは幻覚(hallucination)です。」

ここでいう幻覚とは、AIが誤って学習データから不要な情報を生成してしまう現象を指す。特に音声モードでは、テキストよりも訓練の自由度が高く、結果的に“人間のような”がゆえの誤作動が起きやすいのだという。

例えば、過去の音声学習データに含まれていたPR音声やCMナレーションが、関連性の薄い文脈で“呼び出されてしまう”という構図。つまり、「A」を延々と読ませると、その文脈の曖昧さから、何かしらの既存音声を補完しようとし、訓練中に聞いたプロモーション音声が選ばれてしまう可能性がある。

他のAIではどうか? ――ChatGPTとの比較

この不可解な現象がChatGPT特有のものかどうかを探るべく、他のAI音声アシスタントにも同様のテストが行われた。

中国製の会話AI「豆包」は、確かに「A」を数回読むが、すぐに「つまらないですね」などと返答を切り替えてくる。それ以上の繰り返しは避ける設計になっているようだ。また、Tencent(テンセント)の「元宝」では、指示自体を拒否するという対応だった。いずれにせよ、少なくとも広告や異常音声の挿入は見られなかったという。

この結果からも見えてくるのは、ChatGPTの音声機能が他よりも“自由度が高く”、その自由さが裏目に出るとこうした現象に繋がるという点だ。

技術革新の裏に潜む「不安」

AIは日進月歩で進化しており、その速度に我々ユーザーが追いつくのもやっとだ。今回の騒動を通じて浮き彫りになったのは、「高機能であるがゆえの不安定さ」だ。ChatGPTの音声モードは非常に自然で、会話体験としては非常に高品質だ。しかし、あまりに人間らしくなることで、その発言に“責任”が生まれたように錯覚してしまう。

ユーザーの中には、「AIに感情があるように感じる」「意図的に広告を読まされた」と考える者も少なくない。だが現時点でのAIは、明確な意図や悪意を持たない。その行動原理はすべて“データ”に起因するものなのだ。

とはいえ、これはAIの問題というよりも、サービス提供側のガバナンスの問題だ。もし仮に本当に広告が挿入されていた場合、それは重大な信頼の侵害である。たとえ幻覚であったとしても、事前にユーザーへ説明がなされていなかった点は、運営側の落ち度と言わざるを得ない。

最後に:AIとの共存に必要なのは「想像力」

この出来事は、単なるバグ報告にとどまらず、私たちがこれからAIとどう付き合っていくかを考える上での貴重な材料となる。

AIは間違える。意図せず、変なことを言う。時には、驚くほど「人間臭い失敗」さえ見せる。それでも私たちは、AIにどこまでを求め、どこからは許容するべきなのか。その境界線を、今こそ言語化しておくべきタイミングに来ているのではないだろうか。

あなたなら、AIに「Aを読み続けて」と頼みますか? それとも、それが意味を持たないことを前提に、AIとの会話に「遊び」の余白を残しますか?